Una estudiante crea inteligencia artificial capaz de traducir lengua de señas

Joven de 20 años ideó una inteligencia artificial para poder captar y reconocer los gestos de personas con discapacidad. Conoce aquí todos los detalles.

- Especialistas en IA ganan terreno en Perú con sueldos altamente competitivos, según líder de Coursera para Latinoamérica

- Usuarios reportan caída de YouTube: plataforma muestra error en página principal

El avance de la tecnología ha traído diversas mejoras con el paso de los años, en los que el entretenimiento humano y el ámbito comercial han sido los principales rubros beneficiados. No obstante, este sector también se actualiza para dar soporte a aquellas personas que más lo necesitan, por ejemplo, a quienes no pueden hablar o no son capaces de comunicarse de forma común

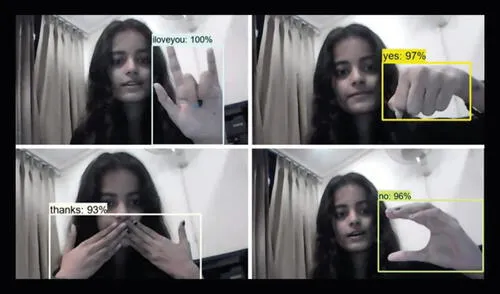

Son varios los desafíos que afrontan estos individuos, quienes en ocasiones necesitan de un componente o producto adicional para poder expresar mejor su lengua de señas. Por ello, en un intento por facilitar este aspecto para este grupo, la joven estudiante de ingeniería Priyanjali Gupta ha creado en la India un modelo de inteligencia artificial que puede comprender estos gestos en tiempo real.

TE RECOMENDAMOS

TEMU VS. ALIEXPRESS: ¡AQUÍ ESTÁN LOS MEJORES PRECIOS! | TECHMOOD

Esta creación se realizó junto al Instituto de Tecnología Vellore, donde se usó un sistema de detección de objetos de Tensorflow para aplicarla en los ordenadores. A diferencia de otros usuarios, Gupta compartió públicamente su creación en su cuenta de LinkedIn, donde demostró las capacidades de su modelo de IA en un video de demostración. Puedes ver el clip a continuación:

PUEDES VER: ¿Cómo usar tu celular Android o iPhone para encontrar cámaras escondidas en una habitación?

“El conjunto de datos se crea manualmente ejecutando el archivo Image Collection Python, que recopila imágenes de su cámara web para todos los signos mencionados a continuación en el lenguaje de señas americano: Hola, te amo, gracias, por favor, sí y no”, explica en sus publicaciones y videos de la red profesional.

Para realizar esto, Priyanjali, de 20 años, comentó que usó como caso de evaluación al dispositivo Alexa, el cual toma comandos cuando habla un usuario.

Recetas

Tallarines verdes peruanos: receta clásica deliciosa (VIDEO)

Cómo preparar un arroz con pollo tradicional riquísimo (VIDEO)

Sudado de pescado (VIDEO)

Escabeche de pollo receta: fácil y buenazo (VIDEO)

Ofertas

Cineplanet

CINEPLANET: 2 entradas 2D + 2 bebidas grandes + Pop corn gigante. Lunes a Domingo

PRECIO

S/ 47.90

Perulandia

PERULANDIA: FULL DAY + Piscinas + S/. 35 o S/.40 de VALE DE CONSUMO + Perusaurus y más. Según elijas

PRECIO

S/ 59.90

VACILANDIA PARK

VACILANDIA: Full Day + Vale de Consumo. Según elijas

PRECIO

S/ 29.90

La Bistecca

ALMUERZO O CENA BUFFET + Postre + 1 Ice tea de Hierba luisa en sus 4 LOCALES

PRECIO

S/ 85.90