ChatGPT se muestra más empático que los médicos humanos al tratar pacientes, según estudio

La inteligencia artificial también brinda información de mayor calidad que los profesionales, indican expertos en salud que evaluaron las respuestas de ambos.

- Geólogos descubren que un abismo entre 2 continentes sigue abriéndose para dar paso a un nuevo océano

- Estudio revela que los terremotos podrían ser responsables de la formación de pepitas de oro en la Tierra

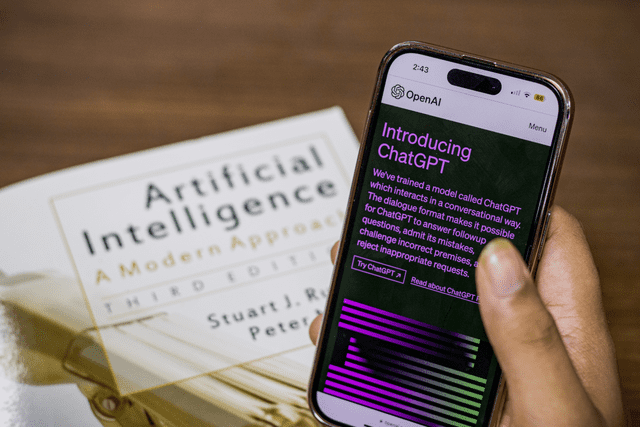

El popular chatbot ChatGPT continúa demostrando más capacidades en el área de la medicina. Ahora, un estudio en Estados Unidos con profesionales de salud ha constatado que este sistema con base en inteligencia artificial (IA) supera a los médicos a la hora de proporcionar respuestas empáticas y de alta calidad a las preguntas escritas de pacientes.

Aunque la IA no sustituirá a los médicos, se sugiere que el trabajo en conjunto de los profesionales con tecnologías como ChatGPT puede "revolucionar la medicina", señala la Universidad de California en San Diego, responsable del estudio, publicado en JAMA Internal Medicine.

Según los resultados, el grupo de profesionales que evaluó las respuestas de ChatGPT prefirió las respuestas de la IA el 79% de las veces, y calificó estas como de mayor calidad y más empáticas.

ChatGPT es un modelo de lenguaje avanzado que utiliza inteligencia artificial para contestar a las preguntas de los usuarios. Foto: Pexels

PUEDES VER: Escáner cerebral con inteligencia artificial consigue leer los pensamientos y traducirlos a palabras

Experimento a ciegas

El equipo, dirigido por John W. Ayers, propuso averiguar si ChatGPT puede responder con precisión a las preguntas que los pacientes envían a sus médicos.

En caso afirmativo, los modelos de IA podrían integrarse en los sistemas sanitarios para mejorar las respuestas de los médicos a las preguntas enviadas por los pacientes, sobre todo después de la pandemia de la COVID-19 con la que se aceleró la asistencia virtual, para así aliviar la carga cada vez mayor que soportan los facultativos.

Para obtener una muestra amplia y diversa de preguntas y respuestas de médicos que no contuvieran información personal identificable, el equipo recurrió a AskDocs, un foro de la plataforma Reddit.

En este grupo, los usuarios publican preguntas que son respondidas por profesionales sanitarios verificados. Aunque cualquiera puede responder a una cuestión, los moderadores revisan las credenciales de los profesionales y las respuestas muestran el nivel de conocimiento del encuestado, explica un comunicado de la universidad.

El equipo seleccionó al azar 195 intercambios de AskDocs en los que un médico verificado respondía a una pregunta pública. Proporcionó la pregunta original a ChatGPT y le pidió que redactara una respuesta.

Un grupo de tres profesionales sanitarios evaluó cada pregunta y las respuestas correspondientes, sin saber si esta procedía de un médico o de ChatGPT. Compararon las respuestas en función de la calidad de la información y la empatía, y señalaron cuál preferían.

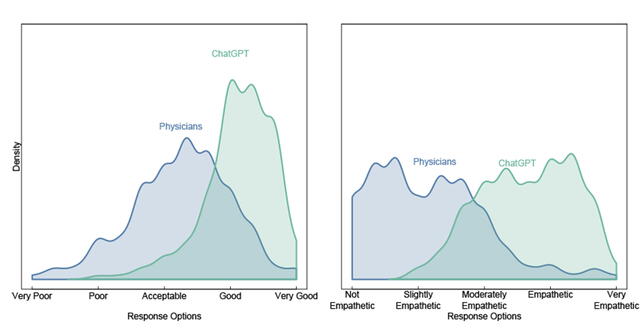

Gráfica que muestra la calidad (izquierda) y la empatía (derecha) de las respuestas de ChatGPT (verde) y los médicos (azul). La puntuación es menor a la izquierda y mayor a la derecha de la tabla. Foto: University of San Diego

Respuestas más empáticas y de mayor calidad

El panel de evaluadores prefirió las respuestas de ChatGPT a las de los médicos en un 79% de las ocasiones.

"Los mensajes de ChatGPT respondían con información matizada y precisa, que a menudo abordaba más aspectos de las preguntas del paciente que las respuestas de los médicos", afirmó Jessica Kelley, coautora del estudio.

Además, la calidad de las respuestas de ChatGPT fue significativamente superior a la de los médicos: las respuestas de calidad buena o muy buena fueron 3,6 veces superiores para ChatGPT.

Las respuestas también fueron más empáticas: las respuestas empáticas o muy empáticas fueron 9,8 veces superiores para la IA.

El objetivo, apuntan los autores, es que un médico aproveche esta IA en su día a día, no sustituir al profesional.

"Estos resultados sugieren que herramientas como ChatGPT pueden redactar eficientemente consejos médicos personalizados de alta calidad para su revisión por parte de los médicos", detalla Christopher Longhurst, del UC San Diego Health.