Geoffrey Hinton: Nobel de Física y ex empleado de Google que alerta sobre los riesgos de la inteligencia artificial

El científico Geoffrey Hinton, galardonado con el Nobel de Física, advierte sobre los peligros potenciales de la inteligencia artificial y la necesidad de una regulación urgente para evitar que esta tecnología evolucione fuera de control y represente una amenaza para la humanidad.

- Adiós a la humedad en casa: arquitecto español revela el truco con papel aluminio para resolver el problema en casi 48 horas

- Científicos descubren una nueva especie de pulpo en las aguas del Pacífico y sería exclusiva en un país de América Latina

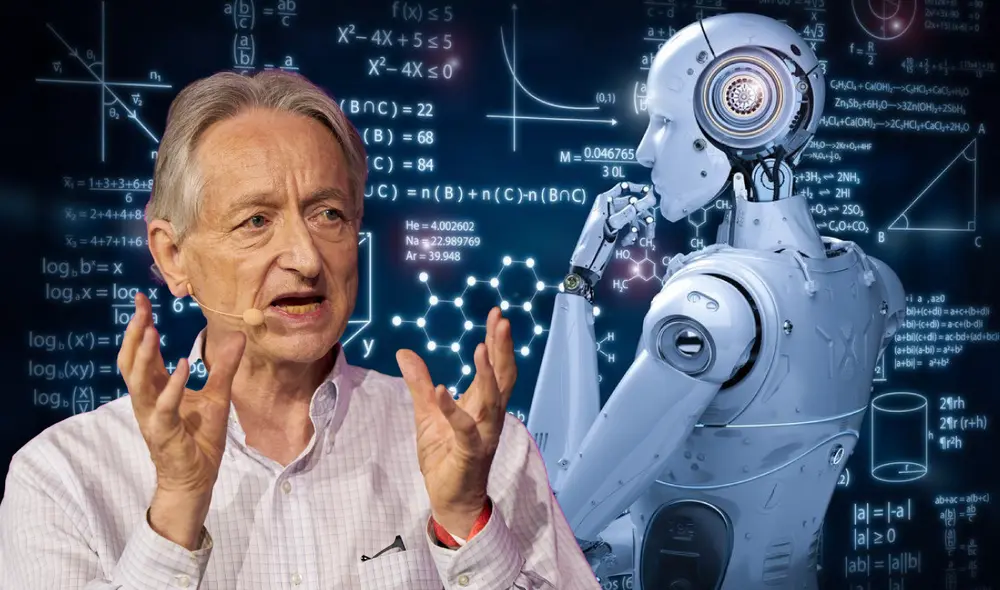

Geoffrey Hinton, conocido como 'el padrino de la inteligencia artificial', ha sido galardonado con el Premio Nobel de Física 2024 por sus contribuciones pioneras al desarrollo de las redes neuronales y el aprendizaje automático. A pesar de los avances tecnológicos que ha ayudado a forjar, el científico alza su voz para advertir sobre los peligros que esta tecnología plantea para la humanidad si no se controla adecuadamente.

Hinton ha hecho un llamado urgente para que la investigación sobre la inteligencia artificial se enfoque en garantizar su seguridad y regulación. Este reconocido especialista en IA sostiene que, si bien los beneficios de la tecnología son innegables, los riesgos que puede acarrear son igual de preocupantes, como la posibilidad de perder el control sobre sistemas que podrían superar las capacidades humanas.

En 2023, Hinton renunció a su puesto en Google para hablar sobre los riesgos de la inteligencia artificial con mayor libertad. Foto: AFP

Inteligencia artificial: ¿un peligro?

Geoffrey Hinton, junto con el físico John Hopfield, ha sido uno de los pioneros en la investigación de las redes neuronales que constituyen la base de la inteligencia artificial moderna. Sin embargo, Hinton alerta que estos avances, que permiten a las máquinas aprender y tomar decisiones de manera autónoma, podrían representar una amenaza si se continúa expandiendo su desarrollo sin una comprensión profunda de sus límites.

El temor de Hinton radica en que la inteligencia artificial evolucione más allá del control humano, lo que podría generar escenarios en los que las máquinas se vuelvan más inteligentes que las personas. "No tenemos experiencia con algo más inteligente que nosotros", afirmó el científico en conferencia de prensa del Nobel. Este escenario, que parece extraído de una película de ciencia ficción, es una preocupación real para Hinton, quien señala que la IA puede traer enormes beneficios en campos como la medicina, pero a la vez podría provocar graves problemas si no se establece una regulación firme que garantice su control.

Uno de los aspectos más alarmantes de la inteligencia artificial es que su desarrollo avanza a un ritmo que supera la capacidad de los investigadores para entender completamente su funcionamiento. Este desconocimiento incrementa el riesgo de que se generen situaciones imprevistas, donde los sistemas de IA podrían actuar de manera autónoma sin supervisión humana, lo que resultaría en una posible pérdida de control.

'Robots asesinos' y desinformación

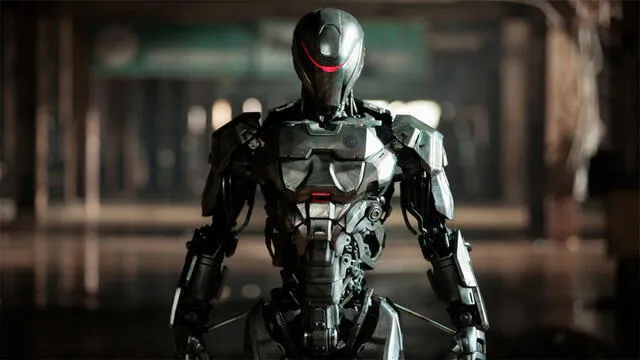

Hinton ha hecho hincapié en los peligros que la inteligencia artificial representa para la estabilidad de la sociedad. Uno de los aspectos más inquietantes es el potencial para el desarrollo de armas autónomas, los llamados 'robots asesinos'. Estos sistemas no solo actuarían sin la intervención humana, sino que podrían tomar decisiones críticas en situaciones de conflicto, poniendo en riesgo vidas humanas sin posibilidad de intervención.

Además, Hinton ha advertido sobre otro peligro menos tangible pero igual de perturbador: la posibilidad de que la inteligencia artificial sea utilizada para crear desinformación masiva. Según el investigador, las plataformas digitales podrían llenarse de contenido falso, como imágenes, videos y textos generados por IA, lo que haría que las personas tengan cada vez más dificultades para discernir entre lo real y lo ficticio. Esta manipulación podría ser utilizada por actores malintencionados para influir en la opinión pública, manipular elecciones o generar conflictos sociales.

El desarrollo de chatbots más avanzados que los humanos, junto con la IA aplicada a la creación de noticias falsas, plantea un serio desafío para la verdad en la era digital. Hinton subraya que esta combinación de factores es "aterradora" y que requiere de una atención urgente por parte de los investigadores y los gobiernos para evitar un escenario en el que la verdad misma se diluya entre los engaños generados por máquinas.

Los 'robots asesinos' se refieren a sistemas de armas autónomas letales capaces de identificar, seleccionar y atacar objetivos sin intervención humana directa. Foto: Invdes

¿Qué se puede hacer al respecto?

A pesar de las preocupaciones manifestadas por Hinton y otros expertos, la carrera por desarrollar sistemas de inteligencia artificial más avanzados no muestra signos de desaceleración. Las grandes empresas tecnológicas como Google y Microsoft están en una competencia feroz para llevar la delantera en el desarrollo de IA, lo que, según Hinton, podría ser un problema difícil de controlar.

Hinton ha propuesto que, además de la investigación científica, los gobiernos y las organizaciones internacionales deben intervenir para establecer regulaciones claras que limiten el desarrollo descontrolado de esta tecnología. En su opinión, los gobiernos deberían obligar a las grandes corporaciones a invertir en la seguridad de la inteligencia artificial y crear infraestructuras que permitan a los investigadores estudiar la IA de manera responsable. "Nuestros mejores investigadores jóvenes, o muchos de ellos, deberían trabajar en la seguridad de la IA, y los gobiernos deberían obligar a las grandes empresas a proporcionar las instalaciones que necesiten para hacerlo", resaltó el experto en declaraciones a los medios.

Uno de los principales desafíos es que, a diferencia de otras tecnologías peligrosas, como las armas nucleares, es difícil controlar el desarrollo de la inteligencia artificial, ya que las empresas pueden trabajar en secreto y fuera de la regulación gubernamental. Hinton subraya que la falta de transparencia en este campo es un riesgo significativo y que se necesita un esfuerzo global para garantizar que la inteligencia artificial no se convierta en una amenaza incontrolable.